정보 엔트로피

정보이론에서 시스템은 송신자, 채널, 수신자를 이용하여 모형화한다. 송신자는 채널을 통해 전달되는 메시지를 만들어낸다. 채널은 특정한 방식을 통해 메시지를 변경한다. 수신자는 어떤 메시지가 보내진 것인지 추론하고자 한다. 이 맥락에서 정보 엔트로피(또는 섀넌 엔트로피)는 각 메시지에 포함된 정보의 기댓값(평균)이다. '메시지'는 어떤 흐름의 정보에 대해서도 모형화할 수 있다.

기술적인 관점에서 보면 정보는 발생 가능한 사건이나 메시지의 확률분포의 음의 로그로 정의할 수 있다. 각 사건의 정보량은 그 기댓값, 또는 평균이 섀넌 엔트로피인 확률변수를 형성한다. 엔트로피의 단위는 정의에 사용된 로그의 밑이 무엇인지에 따라 섀넌(shannon), 내트(nat) 또는 하틀리(hartley)를 사용한다. 단, 섀넌의 경우 보통 비트(bit)로 표현한다.

확률분포의 로그는 엔트로피의 단위로 사용하기에 매우 유용한데 이는 독립적인 소스(source)들에 대해 그 값을 더할 수 있기 때문이다. 예를 들어 동전을 1개 던지면 엔트로피는 1 섀넌이고, m 개의 동전을 던질 때는 m 섀넌이다. n 이 2의 거듭제곱일 때, 일반적으로 n 개의 값 중 하나를 취하는 변수를 표현하기 위해서는 log2(n) 비트가 필요하다. 모든 값의 발생 확률이 동일하면, (섀넌으로 표현된) 엔트로피는 비트의 개수와 동일하게 된다. 비트의 개수와 섀넌이 동일한 경우는 모든 결과의 발생 확률이 동일한 경우로 한정된다. 만약 하나의 사건이 다른 사건보다 발생할 확률이 높다면 그 사건에 대한 관측이 제공할 수 있는 정보는 적다. 반대로 희귀한 사건을 관측하면 더 많은 정보를 얻을 수 있다. 확률이 낮은 사건에 대한 관측은 덜 발생할 것이므로 순 효과는 불균등하게 분포한 자료로부터 얻어진 log2(n) 보다 작은 엔트로피가 된다. 하나의 사건이 확실하게 일어나는 경우라면 엔트로피는 0 이 된다. 섀넌 엔트로피는 소스(source)의 확률분포가 알려져 있을 때 이 모든 고려사항을 수치화한다. 관측된 사건들의 의미(메시지의 의미)는 엔트로피를 정의할 때 중요하지 않다. 엔트로피는 특정한 사건이 일어날 확률만을 고려함으로써 사건의 배후에 존재하는 확률분포에 대한 정보를 캡슐화할뿐 사건 자체의 의미는 포함하지 않는다.

일반적으로 엔트로피는 무질서도 또는 불확실성을 가리킨다. 섀넌 엔트로피의 개념은 클로드 섀넌이 자신의 1948년 논문 "수학적 통신 이론"에서 도입하였다.[1] 섀넌 엔트로피는 정보 소스(source)를 무손실 인코딩 또는 압축할 때 가능한 최상의 평균 길이의 절대적 한계치를 제공해준다. 레니 엔트로피는 섀넌 엔트로피를 일반화한 것이다.

의미

[편집]

요약 : 확률이 낮을수록, 어떤 정보일지는 불확실하게 되고, 우리는 이때 '정보가 많다', '엔트로피가 높다'고 표현한다.

정보 이론의 기본은 어떤 사람이 정보를 더 많이 알수록 새롭게 알 수 있는 정보는 적어진다는 것이다. 어떤 사건의 확률이 매우 높다고 가정하자. 우리는 그 사건이 발생해도 별로 놀라지 않는다. 즉, 이 사건은 적은 정보를 제공한다. 반대로, 만약 사건이 불확실하다면, 그 사건이 일어났을 때 훨씬 유용한 정보를 제공한다. 그러므로, 정보량(information content)은 확률에 반비례한다. 이제 만약 더 많은 사건이 일어난다면, 엔트로피는 실제로 한 사건이 일어났을 때, 얻을 것으로 기대되는 평균 정보량을 측정한다. 주사위 던지기와 동전 던지기를 생각해보자. 주사위 던지기에서 일어나는 한 사건의 확률은 동전 던지기에서 일어나는 한 사건의 확률보다 작다. 즉, 여기서 엔트로피는 주사위 던지기가 동전 던지기보다 크다고 할 수 있다.

그러므로 엔트로피는 '어떤 상태에서의 불확실성', 또는 이와 동등한 의미로 '평균 정보량'을 의미한다. 이 용어를 직관적으로 이해하기 위해 정치에서의 선거를 생각해보자. 보통, 그러한 선거는 우리가 선거 결과를 모르기 때문에 실시한다. 즉, 선거 결과는 상대적으로 '불확실'하다. 그리고 실제로 선거를 시행하고 선거 결과를 얻는 것은 우리에게 '새로운 정보'를 제공한다. 이 말은 선거 결과에 대한 엔트로피가 크다는 말과 같다. 이제, 첫 번째 선거가 실시되고 난 후, 두 번째 선거가 실시되었다고 생각해보자. 첫 번째 선거 결과를 이미 알기 때문에, 우리는 두 번째 선거 결과를 예측할 수 있고 두 번째 선거 결과의 엔트로피가 첫 번째 것보다 작다.

문자 배열로 간주되는 영어 텍스트의 경우, 꽤 낮은 엔트로피를 가지고 있다. 즉, 예상하기 쉽다는 의미이다. 예를 들어 우리가 다음 문자로 무엇이 올지 정확히는 몰라도, 'e'가 'z'보다는 많이 쓰이고 'qu'라는 조합은 'q'와 다른 문자의 조합보다는 훨씬 많다는 것을 알고 있다. 처음 문자 몇 개를 알려주면 나머지 문자를 추측하여 글자를 알아맞히는 일은 어렵지 않다. 영어 문장은 연구 방법에 따라 다르지만 일반적으로 메시지의 글자당 0.6에서 1.3비트의 엔트로피를 갖는다고 알려져 있다.

무손실 압축은 압축된 메시지를 복원함으로써 원래 메시지를 온전히 복원할 수 있음을 의미한다. 무손실 압축된 메시지는 원본 메시지와 정보량은 같지만 더 적은 문자를 가진다. 많은 정보량은 높은 엔트로피를 가지고 있다는 말과 같다. 중복성이 거의 없다는 뜻이다. 개략적으로 말해서, 섀년의 소스 코딩 정리는 무손실 압축이 문자 1비트가 1비트 이상의 정보를 포함하도록 할 수는 없지만, 어떤 코딩 방법에 의해 문자 1비트당 1비트 이하만큼의 정보를 포함하도록 할 수 있다고 말한다. 비트당 메시지의 엔트로피와 메시지 길이의 곱은 전체 메시지가 얼마나 많은 정보를 담고 있는지를 알려준다.

직관적인 이해를 위해, 우리가 ABCD 4가지 문자로 이루어져있는 메시지를 전달한다고 생각해보자. 이 메시지는 'ABADDCAB'이다. 정보 이론은 우리에게 메시지를 전달할 가장 작은 정보량을 계산하는 방법을 제공한다. 만약 4개 글자가 모두 확률이 동일하다면 (25%), A는 00, B는 01, C는 10, D는 11과 같이 2비트로 (바이너리에서) 인코딩하는 수 밖에 방법이 없다. 이제 A가 70%, B가 26%, C와 D가 2%의 확률로 발생한다고 가정하자. 우리는 각각의 문자에 가변 길이 코드를 부여할 수 있다. 우리가 순차적인 2비트의 1 (11)을 받지 않았다면, 1을 받는 것은 다음 비트까지 조사하라는 것을 의미한다. 이 경우에 A는 0 (1비트), B는 10 (2비트), C와 D는 각각 110, 111 (3비트)로 인코딩 될 수 있다. 70%의 경우, 우리는 1비트만 전송하며 26%의 경우 2비트를, 나머지 4%의 경우에만 3비트를 전송한다. 평균적으로, 2비트 이하의 정보를 전송하기 때문에 엔트로피는 감소한다.(A와 B를 합치면 96%라는 높은 출현빈도가 나오기 때문이다)

섀넌의 이론은 어떤 무손실 압축 방식도 모든 메시지를 줄일 수는 없다는 것도 의미한다. 비둘기집 원리에 의해서, 어떤 메시지가 짧게 압축되기 위해서 최소한 다른 하나는 길어져야 한다. 평소에 우리가 횡설수설하는 문서보다는 문법에 따라 쓰인 문장을 압축하는 것처럼, 특정한 형식의 메시지만을 압축하는 것에 집중하기 때문에 압축 알고리즘이 어떤 메시지를 늘리는가는 별로 문제가 되지 않는다. 그러나 이 문제는 이미 압축된 데이터를 다시 압축하려고 할 때 드러난다. 실제로, 우리는 FLAC, MP3, WebM, AAC, PNG, JPEG 같은 압축된 데이터들을 다시 ZIP 형식으로 압축하면 원본 데이터보다 용량이 조금 더 늘어나 있는 것을 목격할 수 있다.

한편, 정보 엔트로피가 커지는것은 역시 변수(불확실성)가 증가하는 것을 의미하므로, 변수를 제어함으로써 불확실성이 줄어드는 것은 결국 정보 획득을 의미하게 된다.

그러므로 획득을 증가시켜 불확실성을 감소시키는 것은 변수가 줄어드는 것으로 볼 수 있는데 이것은 결과적으로 엔트로피의 크기를 감소시키는 정보 이득과 관계있다.[2]

정의

[편집]확률변수 가 분포 를 따른다고 하자. 그렇다면 의 정보 엔트로피 는 다음과 같다.

만약 표본 공간 가 이산공간

이라면, 르베그 적분은 합이 되며, 따라서 정보 엔트로피는 다음과 같다.

간혹, 위 정의에서 자연로그 대신 이진로그 를 사용하는 경우가 있다. 이 경우 정보 엔트로피의 단위는 비트이고, 자연로그의 경우에는 단위 내트(nat)를 사용한다.

조건부 엔트로피

[편집]두 확률변수 가 주어졌고, 그 확률 분포 가 주어졌다고 하자. 그렇다면, 가 주어졌을 때 의 조건부 엔트로피(영어: conditional entropy)는 다음과 같다.

조건부 엔트로피는 항상 음이 아니며, Y값을 알고 있을 때 X값의 무작위한 정도의 양으로 해석될 수 있다. 예를 들어, 6면을 가진 주사위의 엔트로피 H(주사위)를 구하는데, 그 주사위가 1,2,3만 나오도록 조작되어있다는 사실을 알고 있다면, 이것의 엔트로피는 H(주사위 값이 1 또는 2 또는 3)와 같게 된다.

예

[편집]

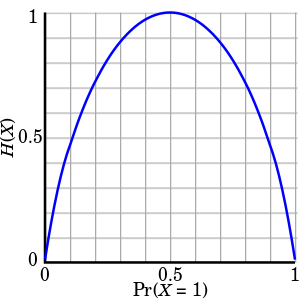

앞에서 언급한 동전던지기 사례를 다시 생각해 보자. 만약 우리가 동전의 특정 면이 나올 확률을 알고 있다고 가정해 보자. (반드시 앞, 뒷면이 나올 확률이 같을 필요는 없다.) 동전 던지기를 시행했을 때 결과값의 엔트로피는 공정한 동전일 때 가장 높게 나온다. (앞, 뒷면이 나올 확률이 각각 1/2로 같을 경우이다.) 이러한 경우가 불확실성을 가장 극대화 시키고 결과값을 예상하기가 가장 어렵다는 것을 의미한다. 이때의 동전던지기 결과값은 1비트에 해당하는 정보를 가지게 된다.

그러나 만약 우리가 이 동전이 공정하지 않다면, 즉 앞면이 나올 확률이 p, 뒷면이 나올 확률을 q로 이미 알고 있다면 불확실성은 더 떨어질 것이다. 이는 동전을 던질 때마다 특정한 면이 나올 확률이 더 높기 때문이다. 이때의 불확실성의 감소는 엔트로피의 감소로 정량화될 수 있다. 공정하지 않은 동전 던지기 결과값의 엔트로피는 1비트의 정보 보다 적다고 해석할 수 있다.

이와 같은 경우 중 가장 극단적인 사례는 양면을 가지고 있으나 절대로 뒷면이 나오지 않는 동전을 사용할 경우이다. 이때에는 불확실성이 전혀 없으므로 (항상 앞면이 나오므로) 엔트로피는 0이다. 즉, 이러한 동전 던지기의 시행결과는 아무런 정보도 전달하지 않는다.

균등분포

[편집]정보 엔트로피의 정의를 이해하기 위해서, 이산균등분포의 엔트로피를 계산해 보자. 표본 공간이 총 n개의 서로 다른 값들로 이루어진다면, 확률 질량 함수는

- 이고, 따라서 엔트로피는

이다.

로그 함수는 독립적인 불확실성에 가산성을 제공하는데 사용된다. 예를 들어, 크기 의 이산 표본 공간과 크기 의 이산 표본 공간에서, 서로 독립이며 균등분포를 따르는 두 확률변수를 동시에 측정할 경우, 그 총 엔트로피는

이 된다. 즉, 서로 독립인 두 확률변수의 엔트로피는 각 확률변수의 엔트로피의 합과 같다.

열역학적 엔트로피와의 관계

[편집]정보이론에서 '엔트로피'라는 단어를 사용하게 된 이유는 섀넌의 공식이 열역학적 엔트로피의 공식과 상당 부분 비슷하기 때문이다.[3] 열역학적 엔트로피 S로서 가장 많이 사용되는 통계열역학에서는 기브스의 엔트로피를 다음과 같이 정의한다.

여기서 kB는 볼츠만 상수를, 그리고 pi는 미시적인 상태의 확률을 의미한다. 기브스엔트로피는 1872년 볼츠만의 연구업적을 뒤이어 조사이어 윌러드 기브스에 의하여 1878년에 정의되었다. 기브스 엔트로피는 또한 변화가 거의 없이 양자물리학에서의 노만 엔트로피로도 변형되는데 이는 1927년 존 폰 노이만에 의해 정의 소개되었으며 다음과 같이 정의된다

여기서 ρ로는 양자역학 시스템에서의 밀도 행렬을 나타내며 Tr은 대각합을 나타낸다.

일상생활의 실용적인 수준에서는 정보이론의 엔트로피와 열역학적 엔트로피의 관계가 그리 깊지는 않다. 물리학자나 화학자는 자발적으로 초기상태에서 멀어지는 시스템에서의 엔트로피 '변화'에 더욱 관심이 있다. 이는 열역학 제2법칙에 부합하는 내용으로, 불변하는 확률분포에 집중하는 정보엔트로피와는 포커싱이 사뭇 다르다.

그러나 여러 학문분야에 걸쳐 종합적인 분석을 해보면, 열역학적 엔트로피와 정보 엔트로피 사이에서는 연결고리가 만들어질 수 있다. 1957년 제인스(영어: Jaynes)의 의견에 의하면, 열역학은 섀넌의 정보 이론의 '응용'으로 간주될 수 있다.[4] 열역학에서의 엔트로피는 시스템의 더욱 자세한 미시적인 상태를 정의하기 위해 더 필요한 섀넌 정보 양의 추정으로 해석될 수 있다. 이는 고전열역학의 미시변수란 개념으로는 설명될 수 없는 것이었다. 예를 들면 시스템에 열을 가하는 것은 열역학적 엔트로피를 증가하는 것이다. 왜냐하면 이것은 미세 상태의 가능한 가짓수를 증가시키기 때문이다. 제임스 클러크 맥스웰은 이론적으로 시스템의 열역학적 엔트로피를 개별적인 분자 상태에 대한 정보를 사용함으로써 감소시킬 수 있다고 주장하였다. 이는 맥스웰의 도깨비란 이름으로 널리 알려져 있다. 그러나 란다우어(Landauer)와 그의 동료들은 총 엔트로피는 줄지 않는다는 것을 보이며 이 역설을 해결하였다.

다양한 분야에서 활용된 엔트로피 개념

[편집]- 아이작 아시모프의 단편 소설 《마지막 질문》.

- 헨리 애덤스의 책 《엔트로피와 생명》. 19세기 미국 역사가 헨리 애덤스는 기계의 힘인 동력과 힘의 쇠퇴인 엔트로피 개념을 포함한 정교한 역사 이론을 주창하였다. 애덤스는 인간 사회가 진보하는 것이 아니라 어쩔 수 없이 쇠퇴하는 것을 자연 상태에서 엔트로피가 커지는 것에 결합하여 설명하였다.

참고 문헌

[편집]- ↑ Shannon, Claude E. (July–October 1948). “A Mathematical Theory of Communication”. 《Bell System Technical Journal》 27 (3): 379–423. doi:10.1002/j.1538-7305.1948.tb01338.x. (PDF, archived from here)

- ↑ 엔트로피 & 정보 이득,Entropy & Information Gain Archived 2017년 8월 19일 - 웨이백 머신

- ↑ Jaynes, E.T. (1957년 5월). “Information Theory and Statistical Mechanics” (PDF). 《Physical Review》 (영어) 106 (4): 620–630. Bibcode:1957PhRv..106..620J. doi:10.1103/PhysRev.106.620.

- ↑ Realated Paper: Vesselin I. Dimitrov, 'On Shannon-Jaynes Entropy and Fisher Information'.

같이 보기

[편집]외부 링크

[편집]- Entropy an interdisciplinary journal on all aspect of the entropy concept. Open access.

- Information is not entropy, information is not uncertainty ! - a discussion of the use of the terms "information" and "entropy".

- I'm Confused: How Could Information Equal Entropy? - a similar discussion on the bionet.info-theory FAQ.

- Description of information entropy from "Tools for Thought" by Howard Rheingold

- A java applet representing Shannon's Experiment to Calculate the Entropy of English

- Slides on information gain and entropy

- An Intuitive Guide to the Concept of Entropy Arising in Various Sectors of Science - a wikibook on the interpretation of the concept of entropy.